Publicado por Oscar Gonzalez

en Rob贸tica

el 29/03/2018

Publicado por Oscar Gonzalez

en Rob贸tica

el 29/03/2018

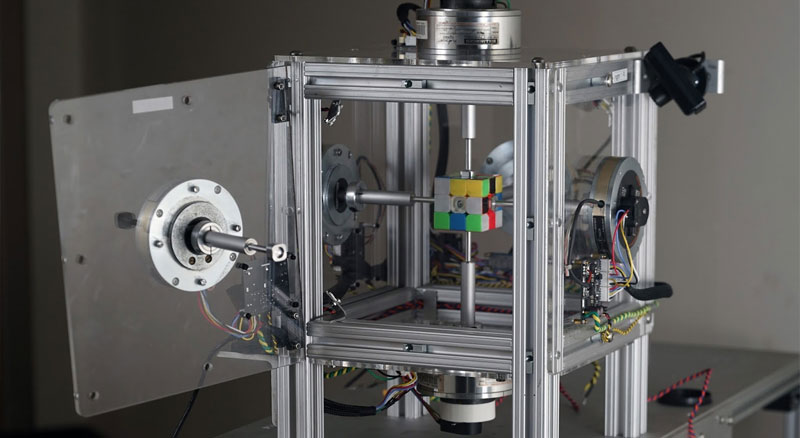

Ya casi es un proyecto clásico pero no deja de sorprenderme. Éste robot especialmente diseñado para dicha tarea, es capaz de resolver el cubo de Rubik en tan solo 0.38 segundos. Usa machine vision con dos cámara PlayStation Eye y unos potentes motores servodisc de Kollmorgen para llegar a tal velocidad, pero también para llegar aquí hubo muchos errores destrozando cubos tal y como muestran los vídeos que os dejo a continuación.

Leer más

Con una Raspberry Pi se pueden hacer muchas más cosas que emular juegos retro, como por ejemplo utilizar la cámara para jugar con reconocimiento facial. El proyecto que te dejo a continuación lo aplica junto con una pequeña pantalla OLED. El sistema consiste en ponerlo delante tuya cuando estás delante del ordenador y cuando reconoce una cara, va contabilizando el tiempo que has pasado delante de tu PC. Una idea simple y a la vez genial que te da una estadística visual y desatendida de las horas que nos pasamos delante de la pantalla.

Leer más

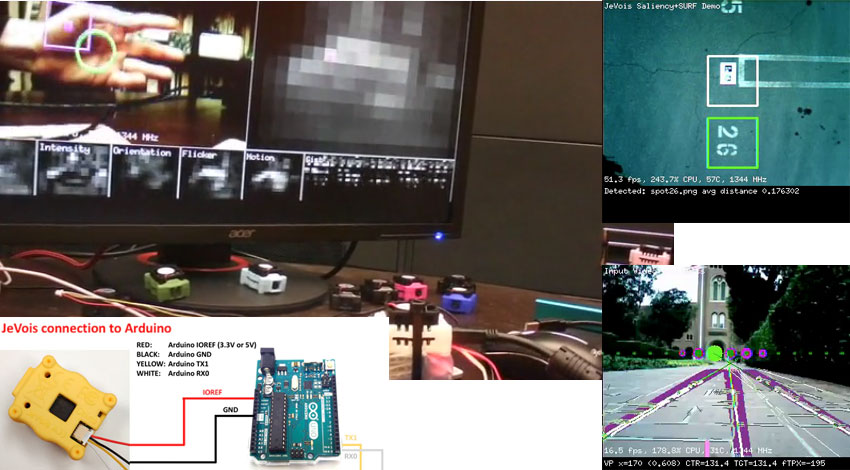

Se llama JeVois y se presenta bajo una campaña en Kickstarter. Se trata de una pequeña cámara que permite añadir reconocimiento por visión a casi cualquier proyecto, ya sea con Raspberry Pi o con Arduino. Es un pequeño dispositivo bastante curioso la verdad y se compone de una cámara CMOS de 1.3MP junto con un potente procesador de cuatro núcleos ARM-v7 de 1.3GHz con un procesador gráfico MALI-400. Pero no te dejes engañar por su pequeño tamaño ya una de las cosas que me han parecido muy interesantes es que mediante una tarjeta de memoria, se le pueden cargar diferentes ficheros de reconocimiento para adaptarlo a diferentes situaciones. Por ejemplo se pueden reconocer códigos QR, objetos de diferentes tipos, trazados de una calzada para navegación automática de vehículos o ojos y caras. El procesamiento de la imagen es realmente muy rápido y puede alcanzar los 200 FPS.

Leer más

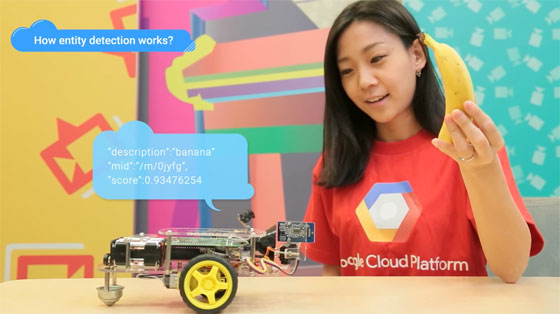

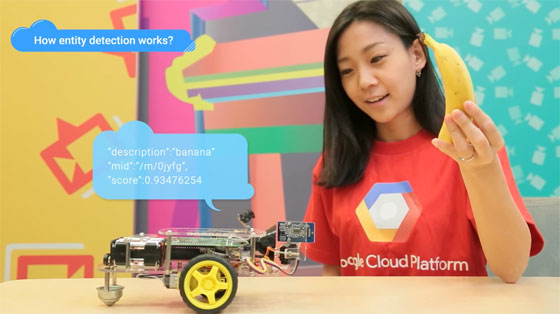

Probablemente ya has montado algún robot con Arduino o incluso te has atrevido a montar con una Raspberry Pi. Existe una infinidad de información en Internet sobre cómo hacer un robot y la mayoría utilizan algún tipo de sensor como los sensores de distancia para poder hacerlo mínimamente interactivo y que reaccione a su entorno. Sin embargo es posible que la nueva Vision API de Google lleve estos robots al siguiente nivel. Google Vision API permite que captures imágenes y enviarlas a su sistema cloud para obtener información sobre la imagen de una forma coherente en formato JSON, fácilmente procesable por cualquier sistema. Con la información procesada en tiempo real, es posible detectar no solo caras por ejemplo, sino también el estado de ánimo como sonriente, triste o asustado. Otra funcionalidad es la posibilidad de reconocer objetos, así podrías hacer que tu robot reaccione de una manera cuando ve una manzana o de otra cuando se trata de un plátano. Esto abre todo un abanico de posibilidades en aplicaciones de robótica por supuesto. El acceso a la API es gratuito hasta 1000 peticiones al mes y luego existen varios planes de pago, así que puedes probarlo sin problema desde su web.

Leer más

Publicado por Oscar Gonzalez

en Rob贸tica

el 13/07/2015

Publicado por Oscar Gonzalez

en Rob贸tica

el 13/07/2015

El Equipo Pegasus ha creado un vehículo autónomo que utiliza algoritmos y técnicas de visión artificial así como los datos de varios sensores, con el fin de seguir los carriles de una carretera, realizar maniobras de aparcamiento y sortear obstáculos bloqueando su camino. Lo interesante de este proyecto es que en primer lugar utiliza un teléfono Android como la unidad que se encarga del procesamiento de imágenes y decisión. Es responsable de transmitir de forma inalámbrica instrucciones para un Arduino que controla los aspectos físicos del vehículo. En segundo lugar, los diversos componentes de hardware ( es decir, sensores , motores , etc.) están programáticamente gestionados de una manera orientada a objetos, una librería desarrollada para Arduino, que permite a los desarrolladores sin experiencia en los sistemas integrados de realizar muy facilmente sus tareas sin preocuparse por los detalles de implementación de bajo nivel. Todos los detalles del proyecto están en su web y también está disponible el código fuente en GitHub por si quieres echar un vistazo.

Leer más